1. Review

지난 시간에는 Self-supervised Learning을 통해서 좋은 weight parameter를 얻고, Transfer Learning을 통해 본인이 가지고 있는 한정된 데이터셋과 할당된 task에 활용해 더 좋은 성능을 얻는 것이 목표였습니다.

2. transformer

트랜스포머는 추후에 조금 더 자세히 기술할 생각입니다. 워낙 블로그에 좋은 글이 많기 때문입니다. 2017년 구글에서 'Attention is all you need' 논문에서 아키텍처를 제안하며 rnn 기반의 seq to seq를 대체하였습니다. 즉, 어텐션만을 활용하여 더 뛰어난 아키텍처를 구성하였고, 이것이 자연스럽게 유행하면서 이를 PLM에 활용하여 유행하게 되었습니다. 이제는 NLP뿐만 아닌 다른 분야에도 많이 활용을 하고 있습니다.

3. transformer in nlp

General 한 텍스트를 학습해 좋은 representation을 만들 수 없을까? 이를 통해 Transfer learning에 활용할 수 없을까? 에 대한 의문에서 출발하였습니다. 3가지 접근이 있는데 아래와 같습니다.

- 더 품질이 뛰어난 임베딩 만들기, feature에 집중하는 것

- 더 좋은 weight parameter를 fine-tuning을 이용해 갖게 하는 것

- GPT 3와 같은 Meta-learning, 큰 모델을 다시 학습할 필요 없이, in-context learning으로 학습 및 추론을 수행하는 것

4. PLM의 장단점

장점은 누구나 손쉽게 SOTA에 근접한 성능 달성이 가능하다는 것이 큰 장점이 되었습니다. 누구나 쉽게 다운 받아 General 한 텍스트들을 활용을 할 수 있습니다. 하지만 단점은 새로운 구조의 모델이나 알고리즘이 아닌 단순히 스케일만 높인다는 경향이 있습니다. (이때 NLP가 제일 재미 없어졌던 시기였던 것 같습니다.)

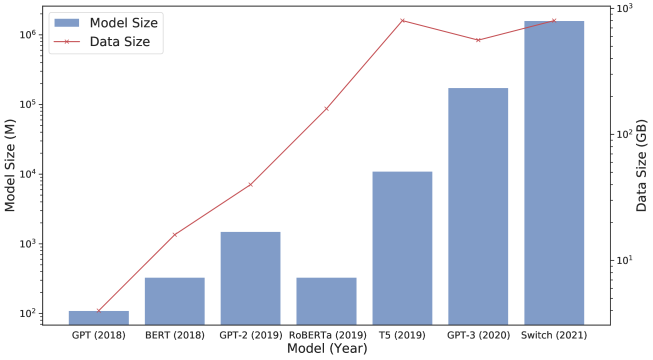

위 그림은 모델과 모델 사이즈 입니다. 숨이 너무 막힐 지경입니다. 대학원과 스타트업에서는 꿈도 못 꿉니다.

2017년 ELMo부터 모델 파라미터 수입니다. exponential 하게 올라가고 있음을 알 수 있습니다. 비용(데이터 크롤링 및 수집 및 GPU)이 엄청나고 NVIDIA만 행복한 그런 그림입니다. (엔비디아 주식 판 게 조금 배가 아프네요.)

5. 정리

수많은 unlabeled corpus를 통해 더 general한 representation을 얻을 수 있는 것이 PLM입니다. 다음 편은 이 PLM을 통해 Fine-tuning을 하는 Downstream task에 대해 논의해보겠습니다.

'AI > NLP' 카테고리의 다른 글

| Pretrained Language Model - 5. Word Embedding (0) | 2021.09.23 |

|---|---|

| Pretrained Language Model - 4. Downstream Task (0) | 2021.09.17 |

| Pretrained Language Model - 2. Transfer Learning (0) | 2021.09.12 |

| Pretrained Language Model - 1. Self-supervised Learning (0) | 2021.09.12 |

| Pretrained Language Model - 0. Intro (0) | 2021.09.12 |