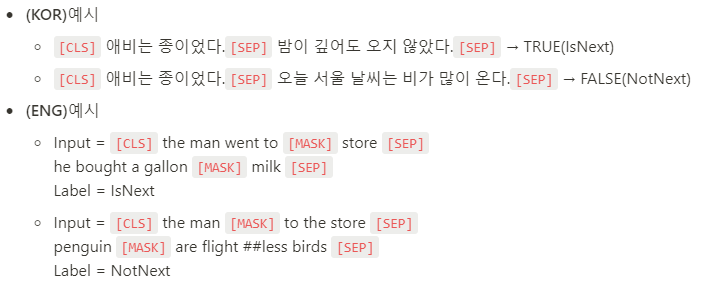

PLM계열의 Auto-Encoder 계열, 가장 많이 쓰이고 활용되고 있는 BERT 차례입니다. 이전에 글 쓴 GPT 계열은 단방향(Uni-directional) 언어 모델이기 때문에, 문장 앞까지만 보고 추측하는 것이기 때문에 문장 전체에 대한 이해가 부족합니다. 마치 한국어는 끝까지 들어봐야 한다라는 말이 있듯이 BERT 계열은 Bi-directional 언어 모델이기 때문에 Fine-Tuning 단계에서 꽤 많은 성능을 올릴 수 있습니다. 0. BERT와 이전 모델의 차이점 - BERT : Performance가 검증된 트랜스포머 블록을 사용 + 모델의 속성이 양방향을 지향하는 점에 있습니다. - GPT는 왼쪽에서 오른쪽으로 한 방향(uni-direction)으로만 보는 아키텍처(언어모델) 입니다...

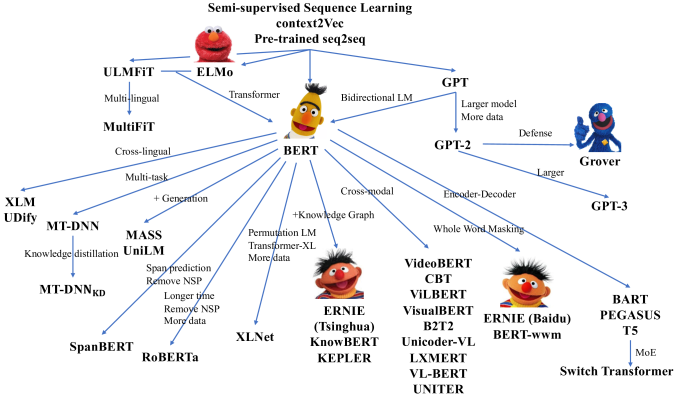

이전 시간에는 Language Model과 Tokenization(BPE Algorithm)에 대해서 다루었습니다. 본격적으로 PLM을 하나씩 언급해볼 예정입니다. 먼저 PLM의 유형들이 어떤 것이 있는지 알아보면 다음과 같습니다. 1. PLM의 유형 - Autoregressive models : Open AI의 GPT와 같이 NLG Task에 강점이 있는 모델을 뜻하며, Transformer의 Decoder만을 이용해 LM을 구성합니다. - Autoencoder models : 가장 많이 활용되며, 구글의 BERT와 같이 NLU Task(CLS, NER 등)에 강점이 있는 모델이며, Transformer의 Encoder를 통해 LM을 구성합니다. Bi-directional LM이 구현 가능하며 MLM,..

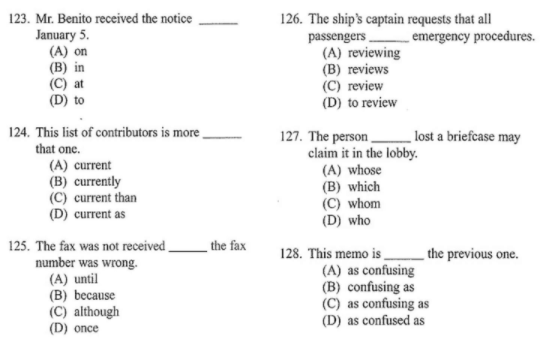

저번 시간 Transformer에 대해 다루었습니다. 조금 더 기초로 돌아가보는 시간 가지겠습니다. NLP에서 가장 근간이 되는 것은 단연 Language Model 입니다. 매우 간단하게 설명하면 토익 Part 5와 같다고 생각하시면 되는데 다음의 빈칸에 알맞은 단어를 고르면 됩니다. 우리 인간은 상당히 많은 말을 일상에서 주고받기 때문에 자연스럽게 단어와 단어사이에 무슨 단어가 들어가야할 지, 어떤 단어가 들어가야 좋은지 학습이 매우 잘 되어 있습니다. 빈칸에 들어갈 확률이 어느게 높은지 잘 학습이 되어있다는 뜻입니다. 언어모델은 위처럼 쉽게 설명하면 그렇지만 수학적으로는 "문장의 확률 분포"를 나타낸 모델이라고 정의할 수 있습니다. 이전 단어들이 주어졌을 때 다음 단어의 확률을 예측하거나, 문장의 ..

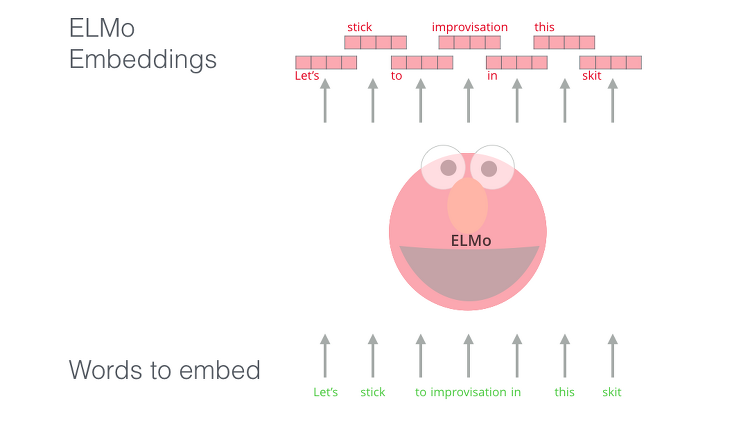

이전 글 Word Embedding에서 동시에 출현하는 단어들이 비슷한 Embedding을 갖도록 학습이 되는 것이 목표라고 이야기를 했었습니다. 하지만 Pre-trained 된 Embedding 벡터를 활용하여 썼을 때 end-to-end 방식보다 성능이 떨어진다고 언급했었습니다. Skip-gram과 같은 Word Embedding 방식들은 단어들이 바뀌다고 해서 문장의 Word Embedding값들이 바뀌는 것이 아닙니다. 해당 Corpus 내의 데이터 셋 내에서는 Global 하게 고정된 것입니다. 정말 간단하게 이야기하면 '배'라는 단어는 3가지 뜻을 가질 수 있습니다. 과일의 배, 바다에 떠다니는 배, 사람 신체의 배 이렇게 동음이의어처럼 이런 경우들은 전부 고정된 임베딩 벡터라는 것이 큰 문제..

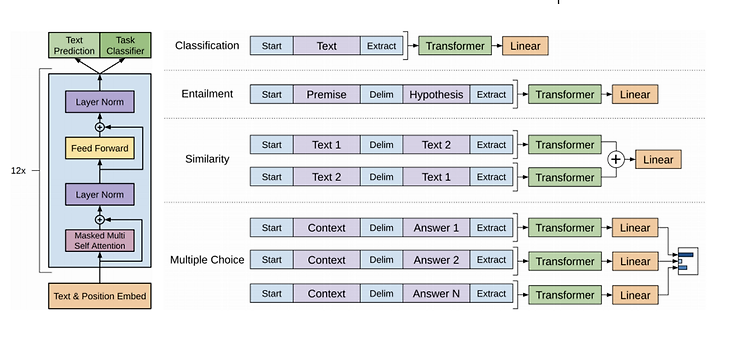

Downstream Task는 간단히 말해 구체적으로 내가 풀고 싶은 문제들을 말합니다. 스택오버플로우에서 퍼온 영문 의미는 아래와 같습니다. Downstream tasks is what the field calls those supervised-learning tasks that utilize a pre-trained model or component. 1. 전형적인 NLP에서의 I/O 빨간색 부분이 Input, 파란색 부분이 Output이라고 할 때, NLP에서 자주 쓰이는 유형은 3가지로 정할 수 있습니다. 1) Many to One : 텍스트 분류 Task가 여기에 해당합니다. 긍정/부정이나 multiclass 등등 제일 많이 활용하는 분야가 분류 Task라고 생각합니다. 2) One to Man..

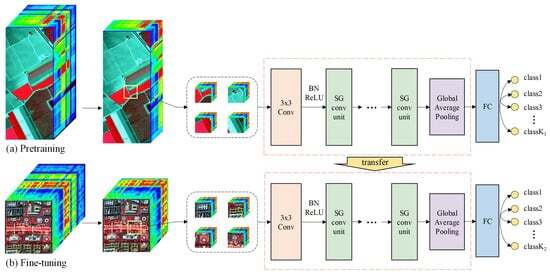

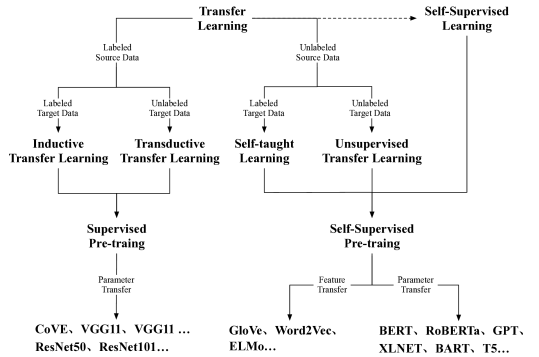

1. Review 지난 시간에는 Self-supervised Learning을 통해서 좋은 weight parameter를 얻고, Transfer Learning을 통해 본인이 가지고 있는 한정된 데이터셋과 할당된 task에 활용해 더 좋은 성능을 얻는 것이 목표였습니다. 2. transformer 트랜스포머는 추후에 조금 더 자세히 기술할 생각입니다. 워낙 블로그에 좋은 글이 많기 때문입니다. 2017년 구글에서 'Attention is all you need' 논문에서 아키텍처를 제안하며 rnn 기반의 seq to seq를 대체하였습니다. 즉, 어텐션만을 활용하여 더 뛰어난 아키텍처를 구성하였고, 이것이 자연스럽게 유행하면서 이를 PLM에 활용하여 유행하게 되었습니다. 이제는 NLP뿐만 아닌 다른 분..

1. Motivations 처음에 전이학습이 나온 분야는 비전입니다. 데이터가 다르더라도 이미지를 활용한 공통된 Feature들이 존재할 것이라고 접근합니다. 꽃은 잎 모양, 길이가 비슷하나 조금씩 다 차이가 있습니다. 최소한의 공통적인 Feature를 활용하겠다는 사상에서 출발을 합니다. 2. Common Feature in NLP NLP에서는 공통적인 Feature들을 어떻게 뽑을 수 있을까요? I love to go to market. I would like to go home. You have to go to school. .... Corpus에 위와 같은 쉬운 표현들을 보면 semantic, syntactic 한 요소들이 사람이 보기에 쉽게 보일 수 있습니다. I wish to precariou..

1. comparison of Supervised vs. Unsupervised Learning Supervised Learning은 머신러닝 공부할 때 가장 제일 처음 나오는 부류의 학습방법입니다. label y와 data input의 관계를 학습합니다. 반면 Unsupervised Learning은 label y가 존재하지 않고 data x 분포 자체를 학습하거나 x의 feature를 학습하여 활용합니다. 2. Supervised learning 많은 데이터에 사람이 직접 label을 답니다. 이를 통해 입력 x와 output y사이의 관계를 학습합니다. Data y에 label을 다는 것이 인형에 눈알을 다는 것으로 행위가 유사하다고 빗대는데, 실제로 label을 다는 것은 정말 고되고 힘듭니다. ..